Novas GPUs de arquitetura Ampere da NVIDIA Enterprise estão agora em plena produção com demanda recorde

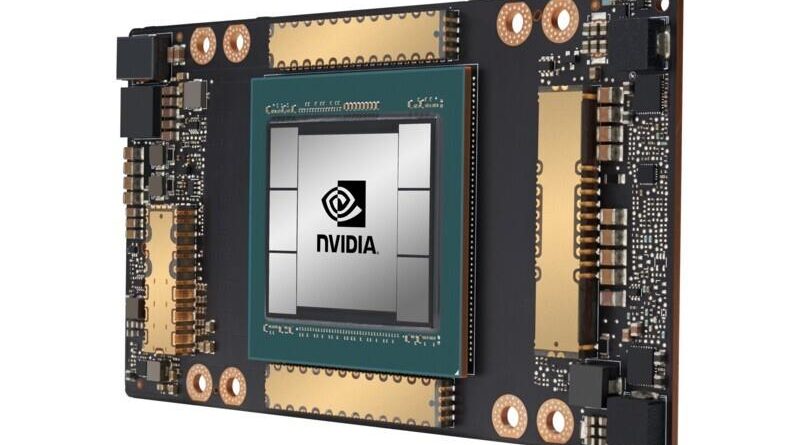

A NVIDIA Enterprise anuncia que a primeira GPU baseada na arquitetura Ampere da NVIDIA, a NVIDIA A100, está em plena produção e será entregue aos clientes em todo o mundo.

A A100 conta com os avanços de design da arquitetura NVIDIA Ampere, que oferecem o maior salto em desempenho da empresa até hoje em suas oito gerações de GPUs, para unificar o treinamento e a inferência de IA e potencializar o desempenho em até 20 vezes em comparação com suas antecessoras. Sendo uma aceleradora de carga de trabalho universal, a A100 também foi desenvolvida para análise de dados, computação científica e gráficos na nuvem.

“As poderosas tendências da computação em nuvem e da IA estão impulsionando uma mudança tectônica nos projetos de data centers, de modo que o que antes era um mar de servidores apenas com CPU agora é computação acelerada por GPU”, conta Jensen Huang, fundador e CEO da NVIDIA. “A GPU NVIDIA A100 é um salto de desempenho de 20 vezes em IA e um acelerador de aprendizado de máquina de ponta a ponta – da análise de dados ao treinamento e à inferência. Pela primeira vez, as cargas de trabalho de ampliação e expansão podem ser aceleradas em uma plataforma. A NVIDIA A100 aumentará simultaneamente a taxa de transferência e reduzirá o custo dos data centers.”

As novas tecnologias de computação elástica incorporadas à A100 possibilitam trazer a capacidade de computação do tamanho certo para todos os trabalhos. Um recurso de GPU de múltiplas instâncias permite que cada GPU A100 seja particionada em até sete instâncias de “mini-GPU” para tarefas de inferência menores, enquanto a tecnologia de interconexão NVIDIA NVLink de terceira geração permite que várias GPUs A100 operem como uma GPU gigante para tarefas de treinamento ainda maiores.

Os provedores de serviços em nuvem e criadores de sistemas líderes do mundo que esperam incorporar GPUs A100 em suas ofertas incluem: Alibaba Cloud, Amazon Web Services (AWS), Atos, Baidu Cloud, Cisco, Dell Technologies, Fujitsu, GIGABYTE, Google Cloud, H3C, Hewlett Packard Enterprise (HPE), Inspur, Lenovo, Microsoft Azure, Oracle, Quanta/QCT, Supermicro e Tencent Cloud.

“As novas GPUs NVIDIA A100 vão otimizar ainda mais o tempo dos cientistas e pesquisadores ao redor do mundo, incluindo o Brasil. Com um potencial até 20 vezes melhor que as antecessoras, podemos esperar grandes inovações tecnológicas no mercado”, explica Marcio Aguiar, gerente sênior da NVIDIA Enterprise para América Latina.

Adoção imediata global

Entre os primeiros a utilizar o poder das GPUs NVIDIA A100 está a Microsoft, que aproveitará o desempenho e a escalabilidade das A100.

“A Microsoft treinou a Turing Natural Language Generation, o maior modelo de idioma do mundo, em escala usando a geração atual de GPUs NVIDIA”, diz Mikhail Parakhin, vice-presidente corporativo da Microsoft Corp. “O Azure permitirá o treinamento de modelos de IA dramaticamente maiores usando a nova geração de GPUs A100 da NVIDIA para aprimorar o estado da arte em linguagem, fala, visão e multimodalidade.”

DoorDash, uma plataforma de comida sob demanda que serve como uma tábua de salvação para restaurantes durante a pandemia atual, observa a importância de ter uma infraestrutura de IA flexível.

“As cargas de trabalho modernas e complexas de treinamento e inferência de IA que exigem uma grande quantidade de dados podem se beneficiar da tecnologia de última geração, como as GPUs NVIDIA A100, que ajudam a reduzir o tempo de treinamento do modelo e acelerar o processo de desenvolvimento de aprendizado de máquina”, afirma Gary Ren, engenheiro de machine learning na DoorDash. “Além disso, o uso de clusters de GPU baseados em nuvem nos oferece uma nova flexibilidade para aumentar ou diminuir conforme necessário, ajudando a melhorar a eficiência, simplificar nossas operações e economizar custos.”

Outros primeiros utilizadores incluem laboratórios nacionais e algumas das principais instituições de ensino superior e pesquisa do mundo, e todos estão usando a tecnologia da A100 em seus supercomputadores de última geração. Eles incluem:

- Universidade de Indiana, nos EUA, cujo supercomputador Big Red 200 baseado no sistema Cray Shasta da HPE, aceitará pesquisas científicas e médicas e pesquisa avançada em inteligência artificial, machine learning e análise de dados.

- Jülich Supercomputing Centre, na Alemanha, cujo sistema booster JUWELS está sendo criado pela Atos, foi projetado para tarefas de inteligência artificial e potência de computação extrema.

- Instituto de Tecnologia de Karlsruhe, na Alemanha, que está construindo seu supercomputador HoreKa com a Lenovo, poderá realizar simulações de várias escalas significativamente maiores no campo de ciência de materiais, ciências do sistema terrestre, engenharia para pesquisa de energia e mobilidade, além de física de partículas e astropartículas.

- Max Planck Computing and Data Facility, na Alemanha, com seu supercomputador Raven da nova geração, construído pela Lenovo, oferece suporte de alto nível para o desenvolvimento, otimização, análise e visualização de aplicativos de computação de alto desempenho para os Institutos Max Planck.

- Centro Nacional de Computação de Pesquisa Científica de Energia do Departamento de Energia dos EUA, localizado no Laboratório Nacional da Lawrence Berkeley, que está desenvolvendo seu supercomputador Perlmutter de última geração baseado no Cray Shasta da HPE para oferecer suporte a ciência de escala extrema e desenvolver novas fontes de energia, melhorar a eficiência energética e descobrir novos materiais.

Cinco inovações da A100

A GPU NVIDIA A100 é uma revolução do design técnico e conta com cinco inovações importantes:

- Arquitetura NVIDIA Ampere — No coração da A100 se encontra a arquitetura de GPU NVIDIA Ampere, que contém mais de 54 bilhões de transistores, fazendo com que seja o maior processador de 7 nanômetros do mundo.

- Tensor Cores de terceira geração com o TF32 — Os Tensor Cores amplamente adotados pela NVIDIA agora são mais flexíveis, mais rápidos e fáceis de usar. Seus recursos expandidos incluem o novo TF32 para IA, que permite até 20 vezes o desempenho de IA da precisão do FP32 sem nenhuma alteração de código. Além disso, o Tensor Cores agora tem suporte ao FP64, oferecendo uma computação até 2,5 vezes maior do que a geração anterior para aplicativos de HPC.

- GPU de instâncias múltiplas — O MIG, um novo recurso técnico, permite que uma única GPU A100 seja particionada em até sete GPUs separadas para que possa oferecer vários graus de computação para trabalhos de diferentes tamanhos, proporcionando uma utilização ideal e maximizando o retorno sobre o investimento.

- NVIDIA NVLink™ de terceira geração — Dobra a conectividade de alta velocidade entre as GPUs para oferecer escala de desempenho eficiente em um servidor.

- Dispersão estrutural — Essa nova técnica de eficiência utiliza a natureza inerentemente esparsa da matemática de IA para dobrar o desempenho.

Juntos, esses novos recursos tornam a NVIDIA A100 ideal para cargas de trabalho diversificadas e exigentes, incluindo treinamento e inferência de IA, simulação científica, IA de conversação, sistemas de recomendação, genômica, análise de dados de alto desempenho, modelagem sísmica e previsões financeiras.

NVIDIA A100 disponível em novos sistemas e em breve na nuvem

O sistema NVIDIA DGX™ A100, também anunciado pela NVIDIA Enterprise, dispõe de oito GPUs NVIDIA A100 interconectadas com o NVIDIA NVLink. Ele foi disponibilizado imediatamente pela NVIDIA e pelos parceiros aprovados.

Alibaba Cloud, AWS, Baidu Cloud, Google Cloud, Microsoft Azure, Oracle e Tencent Cloud planejam oferecer serviços baseados na A100.

Além disso, uma ampla variedade de servidores baseados na A100 é esperada dos principais fabricantes de sistemas do mundo, incluindo Atos, Cisco, Dell Technologies, Fujitsu, GIGABYTE, H3C, HPE, Inspur, Lenovo, Quanta/QCT e Supermicro.

Para ajudar a acelerar o desenvolvimento de servidores de seus parceiros, a NVIDIA Enterprise criou o HGX A100 — um bloco de construção de servidor na forma de placas base integradas em várias configurações de GPUs.

A HGX A100 de quatro GPUs oferece interconexão completa entre as GPUs com o NVLink, enquanto a configuração de oito GPUs oferece largura de banda completa de GPU por meio do NVIDIA NVSwitch™. A HGX A100, com a nova arquitetura de GPU de instâncias múltiplas, pode ser configurada como 56 GPUs pequenas, cada uma delas sendo mais rápida do que a NVIDIA T4, e até um servidor gigante com oito GPUs e 10 petaflops de desempenho de IA.

Otimizações de software NVIDIA para a A100

A NVIDIA também anunciou várias atualizações em seu conjunto de software, que permitem que os desenvolvedores de aplicativos aproveitem as inovações da GPU A100. Isso inclui novas versões de mais de 50 bibliotecas CUDA-Xusadas para acelerar gráficos, simulações e IA; CUDA 11; NVIDIA Jarvis, uma estrutura de serviços de IA de conversação multimodal; NVIDIA Merlin, uma estrutura de aplicação produnda; e o NVIDIA HPC SDK, que inclui compiladores, bibliotecas e ferramentas que ajudam os desenvolvedores de HPC a depurar e otimizar seu código para A100.

NVIDIA

Com a invenção da GPU pela NVIDIA (NASDAQ: NVDA), em 1999, redefinimos os gráficos de computadores modernos e revolucionamos a computação paralela. Mais recentemente, o deep learning com base em GPU deu início à inteligência artificial moderna — a próxima era da computação — com a GPU atuando como o cérebro dos computadores, robôs e carros autônomos que podem perceber e compreender o mundo. Saiba mais em http://nvidianews.nvidia.com/

Acesse também:

Site oficial da NVIDIA no Brasil: https://www.nvidia.com/pt-br/

Facebook: @NVIDIABrasil

Twitter: @NVIDIABrasil